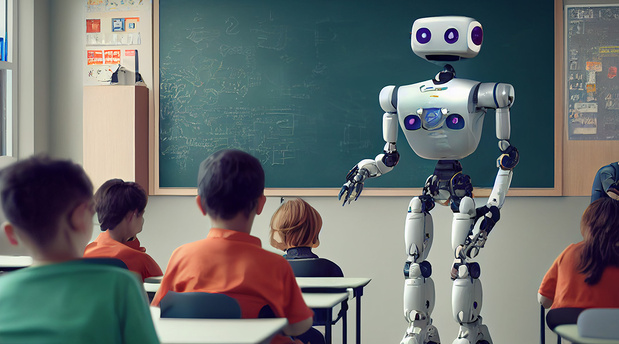

Les technologies modernes de l’IA entravent gravement la capacité des humains à apprendre et à conserver des compétences, tout en rendant presque impossible pour les universitaires et autres experts de cultiver et de diffuser des connaissances. De nombreux chercheurs, dont nous faisons partie, ont mis en évidence la menace que représente le techno-solutionnisme dans le domaine de l’éducation : Au lieu d’élargir nos horizons intellectuels, ces technologies sapent les conditions mêmes qui nous permettent de penser par nous-mêmes.

En réalité, les réalisations apparentes de ces systèmes reposent sur le du travail intellectuel des humains. Les grands modèles de langage (LLM) ont notamment été formés en et des travaux universitaires sans le consentement des auteurs ou des éditeurs, en les fragmentant et en les remixant pour en faire des présentés comme des .

Selon le discours de l’industrie de l’IA, toute la créativité, l’innovation et les connaissances humaines sont essentiellement automatisables, ce qui rend les personnes obsolètes. Même les partisans d’une « » partent de ce principe.

Pourtant, les études sur l’automatisation et les sciences cognitives, ainsi que la longue histoire des cycles d’expansion et de récession de l’IA, démontrent que les affirmations générales d’automatisation quasi-totale sont , et . L’automatisation – même lorsqu’elle fonctionne – doit opérer à un niveau bien inférieur à ce pour réussir sans éroder les compétences et l’action des opérateurs humains.

En fin de compte, la stratégie collective des entreprises d’IA menace de déqualifier précisément les personnes qui sont essentielles au fonctionnement de la société. Après tout, quelle valeur y a-t-il à automatiser l’art, la pensée ou la lecture – en particulier dans les ? Aucune. Au contraire, l’automatisation de la connaissance et de la culture par des entreprises privées est une qui évoque des scénarios et .

La déqualification, le dénigrement et le déplacement des enseignants et des universitaires ont toujours été au cœur des prises de pouvoir fascistes, car les éducateurs servent de remparts contre la propagande, l’anti-intellectualisme et l’analphabétisme. Aujourd’hui, les partisans de l’IA ne se contentent pas de supposer que l’automatisation est nécessaire ; ils font un prosélytisme agressif de leur foi, ouvrant ainsi la voie au techno-fascisme.

Les universitaires existent, en partie, pour dire la vérité au pouvoir, ce qui exige qu’ils soient indépendants de l’influence des gouvernements et des entreprises. Les États-Unis démontrent aujourd’hui les conséquences de l’affaiblissement de la liberté académique, de la pensée critique et de l’impartialité, alors que l’administration du président Donald Trump et les entreprises de Big Tech collaborent pour saper la capacité des institutions académiques à soutenir le type de travail scientifique qui expose les fausses promesses de l’IA.

Pire encore, l’assaut techno-fasciste contre les universités vient de plus en plus de l’intérieur. Ces dernières années, l’industrie de l’IA est , a coopté les syndicats de professeurs et a même enrôlé des enseignants et des chercheurs pour promouvoir ses outils auprès de leurs collègues et de leurs étudiants. Loin d’offrir de véritables solutions, ces technologies exacerbent les et corrodent l’.

Dans une récente, nous avons remis en question les affirmations avancées par l’industrie de l’IA. Alors que les entreprises nous incitent à embrasser – et même à célébrer – leur futur technologique imaginé et , les universitaires et leurs alliés doivent adopter une et défendre les universités et les institutions savantes en interdisant l’accès aux technologies toxiques et addictives dans les salles de classe.

L’industrie compte sur nous pour oublier que nous sommes déjà passés par là. Les universités ont longtemps été utilisées pour blanchir des produits nocifs, et l’intelligence artificielle elle-même a été à plusieurs reprises au cours de divers cycles de battage médiatique. En fait, le terme « intelligence artificielle », inventé en 1955, a toujours été davantage une expression marketing qu’une classification taxonomique.

Pour soutenir la de l’, l’industrie s’appuie sur un – en prétendant que les modèles « pensent », « raisonnent » et « » pour suggérer des capacités cognitives qu’ils et qu’ils ne développeront peut-être jamais. Cette astuce rhétorique non seulement exagère les capacités des produits, mais en humanisant faussement les machines, ce qui explique pourquoi de nombreux éducateurs et étudiants ont commencé à IA.

En réponse, l’industrie de l’IA a fait pression sur les agences gouvernementales pour qu’elles rendent obligatoire l’utilisation de ses produits, affirmant que sans eux, les étudiants ne seront pas préparés au marché du travail. En réalité, c’est l’inverse qui est nécessaire : les universitaires spécialisés dans les domaines liés à l’IA doivent avoir la liberté de critiquer ces technologies, tandis que ceux qui travaillent dans d’autres domaines doivent pouvoir enseigner sans subir l’ingérence d’entreprises désireuses de gagner de l’argent.

Les objectifs de l’industrie – qu’il s’agisse de l’industrie du tabac, du pétrole, des produits pharmaceutiques ou de la technologie – s’alignent rarement sur le bien-être humain ou la recherche désintéressée, en particulier lorsqu’ils ne sont pas contrôlés ni . Au contraire, leur intérêt est de maximiser le profit et le pouvoir de marché. L’industrie de l’IA n’est pas différente, et les éducateurs devraient répudier ses fausses promesses.

Ce commentaire est basé sur un travail conjoint avec Marcela Suarez et Barbara Müller.

Olivia Guest est professeur adjoint en sciences cognitives computationnelles à l’université Radboud. Iris van Rooij est professeur de sciences cognitives computationnelles à l’université Radboud.

© Project Syndicate 1995–2025